Công ty OpenAI đã sử dụng công nhân Kenya với mức lương chưa đến $2 mỗi giờ để làm cho chatbot trí tuệ nhân tạo (AI) ChatGPT ít độc hại hơn. Tung ra vào Tháng Mười Một 2022, ChatGPT được ca ngợi là “một trong những cải tiến công nghệ ấn tượng nhất của năm 2022”.

Công cụ mạnh mẽ này có thể tạo text (văn bản) cho hầu hết mọi chủ đề, từ một bản sonnet của Shakespeare được soạn lại theo phong cách của Megan Thee Stallion, đến các định lý toán học phức tạp được mô tả bằng ngôn ngữ mà một đứa trẻ 5 tuổi có thể hiểu được! Chỉ trong vòng một tuần, nó đã có hơn một triệu người dùng.

Để làm cho ChatGPT ít độc hại hơn

OpenAI, cha đẻ của ChatGPT được cho là đang đàm phán với các nhà đầu tư để huy động vốn lên đến $29 tỷ, kể cả khoản đầu tư tiềm năng $10 tỷ từ gã khổng lồ Microsoft. Nếu thành công, OpenAI, được thành lập tại San Francisco năm 2015 với mục đích xây dựng những cỗ máy siêu thông minh, sẽ trở thành một trong những công ty AI có giá trị nhất thế giới.

Nhưng câu chuyện thành công của nó không chỉ nằm trong cái nôi công nghệ Silicon Valley mà còn lan đến tận châu Phi. Trong một nỗ lực để làm cho ChatGPT ít độc hại hơn, OpenAI đã sử dụng hàng chục lao động Kenya với mức thù lao chưa đến $2 mỗi giờ để góp phần hoàn thành mục tiêu này – cuộc điều tra của tờ TIME đã phát hiện. Công việc “sạch hoá” này rất quan trọng đối với OpenAI. GPT-3, sản phẩm “tiền nhiệm” của ChatGPT, đã thể hiện khả năng ấn tượng nhưng thường xuyên đưa ra những text bạo lực, dâm dục, phân biệt giới tính và chủng tộc.

Nguyên nhân là do AI của GPT-3 được huấn luyện dựa vào hàng trăm tỷ từ (word) “thượng vàng hạ cám” thu thập từ internet. Nếu rà soát đống dữ liệu khổng lồ này theo cách thủ công, phải cần hàng trăm người làm việc trong nhiều thập niên. Muốn hạn chế tác hại của ChatGPT thì phải xây dựng được một cơ chế an toàn bổ sung cho AI để ChatGPT có thể trở thành một “chatbot của mọi người”. Lúc đó tiền sẽ vào như nước do có nhiều người mua hơn.

OpenAI đã học cách các công ty truyền thông xã hội như Facebook hoàn thiện AI phát hiện ngôn ngữ độc hại như ngôn ngữ căm thù và loại bỏ “rác rến” khỏi nền tảng của họ. Nhưng trước hết, phải cung cấp cho AI các ví dụ về bạo lực, ngôn từ kích động thù địch và lạm dụng tình dục để nó học cách tự phát hiện những “độc tính” đó trong thế giới thực. Phần mềm phát hiện sẽ được tích hợp vào ChatGPT để nó loại bỏ những text và hình ảnh, video độc hại trước khi đến người dùng.

Để làm điều này, OpenAI đã gửi hàng chục ngàn đoạn text đến một công ty gia công phần mềm ở Kenya, từ Tháng Mười Một 2021 để giúp sàng lọc và phân loại. Một số liên quan đến lạm dụng tình dục trẻ em, thú tính, giết người, tự tử, tra tấn, tự làm hại bản thân và loạn luân.

Đối tác gia công phần mềm của OpenAI ở Kenya là Sama, một công ty đặt trụ sở chính tại San Francisco chuyên tuyển nhân viên lương thấp tại ba quốc gia Kenya, Uganda và Ấn Độ để “đánh dấu” các dữ liệu cần sàng lọc cho các khách hàng ở Silicon Valley như Google, Meta và Microsoft. Sama tự quảng cáo là “một công ty AI có đạo đức” và tuyên bố đã giúp hơn 50,000 người nghèo thoát nghèo.

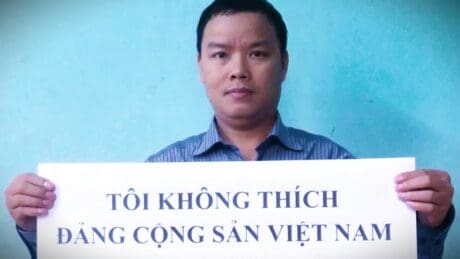

Những người làm công việc “đánh dấu” do Sama tuyển dụng thay mặt OpenAI được trả mức lương rẻ rúng từ khoảng $1.32 đến $2 mỗi giờ tùy thuộc thâm niên và hiệu suất công việc. TIME đã xem xét hàng trăm trang tài liệu nội bộ của Sama và OpenAI, gồm cả phiếu lương của nhân viên Sama và phỏng vấn bốn người Kenya làm việc trong dự án của OpenAI (tất cả đều giấu tên vì lo cho sinh kế của họ).

Câu chuyện của những người làm công

Câu chuyện về những người lao động giúp hoàn thiện ChatGPT có thể cung cấp cái nhìn sâu hơn về điều kiện làm việc trong một lĩnh vực ít được biết đến này của ngành công nghiệp AI nhưng lại giữ vai trò quan trọng để làm cho các hệ thống AI an toàn hơn khi đến người tiêu dùng. Ở đây là ChatGPT. “Dù công việc của họ được xem là thiết yếu, nhưng ngày càng có nhiều tiết lộ cho thấy điều kiện làm việc bấp bênh mà những người lao động này phải đối mặt – Partnership on AI (một liên minh các tổ chức AI gồm cả OpenAI) nhận định.

Tuy nhiên, điều kiện làm việc của những người làm công việc sàng lọc dữ liệu đã cho thấy “phần đen tối” của bức tranh, so với bề ngoài hào nhoáng của nó. Thực tế cho thấy “những người lao động vô hình bị tranh công” này vẫn ở bên lề ngay cả khi công việc của họ đóng góp rất lớn cho các ngành công nghiệp trị giá hàng tỷ đôla.

Một nhân viên Sama được giao nhiệm vụ đọc và “đánh dấu” dữ liệu xấu cho OpenAI nói với TIME ông “thường xuyên bị ám ảnh” sau khi xem hình ảnh một người đàn ông quan hệ tình dục với một con chó trước mặt một đứa trẻ. “Đó là sự tra tấn – ông nói – Bạn phải đọc và nhìn những thứ như thế suốt cả tuần!”. Cuối cùng, không thể chịu nổi những gì mà các nhân viên chứng kiến, Sama phải hủy hợp đồng với OpenAI vào Tháng Hai 2022, sớm hơn tám tháng so với thời hạn.

Các tài liệu được TIME xem qua cho thấy OpenAI đã ký ba hợp đồng tổng trị giá khoảng $200,000 với Sama vào cuối năm 2021 để thuê các nhân viên chuyên “đánh dấu” (dán nhãn) những dữ liệu lạm dụng tình dục, ngôn từ kích động thù địch và bạo lực. Khoảng ba chục nhân viên được chia thành ba đội, mỗi đội tập trung vào từng loại dữ liệu cần đánh dấu. Bốn nhân viên được TIME tiếp cận cho biết họ phải đọc và đánh dấu từ 150 đến 250 đoạn text “bẩn thỉu” chứa từ 100 đến hơn 1,000 từ trong mỗi ca làm việc dài 9 giờ.

Tất cả than phiền họ bị tổn thương tinh thần nghiêm trọng trong khi các buổi tư vấn “sức khỏe” hiếm hoi hầu như không mang lại kết quả gì. Một người cho biết việc yêu cầu gặp cố vấn trực tiếp đã bị ban quản lý Sama từ chối nhiều lần. Các hợp đồng nêu rõ OpenAI sẽ trả lương $12.5 mỗi giờ công cho Sama, gấp sáu đến chín lần số tiền mà nhân viên Sama tham gia dự án nhận. Theo ba nhân viên bậc thấp nhất của Sama, mức lương cơ bản là khoảng $170 mỗi tháng, ngoài tiền thưởng hàng tháng chừng $70 và sẽ nhận được hoa hồng khi đáp ứng các chỉ số hiệu suất chính như độ chính xác và tốc độ làm việc.

Một nhân viên làm việc theo ca chín tiếng có thể mang về nhà ít nhất $1.32 mỗi giờ sau thuế, tăng lên $1.44 mỗi giờ nếu vượt chỉ tiêu. Còn các nhà phân tích chất lượng, kiểm tra công việc của nhân viên có thể kiếm được $2 mỗi giờ nếu đạt chỉ tiêu. Người phát ngôn của Sama cho biết các công nhân chỉ được yêu cầu sàng lọc 70 text mỗi ca, không phải tối đa 250 như họ nói và mỗi người có thể kiếm được từ 1.46 đến $3.74 mỗi giờ sau thuế.

Tháng Hai 2022, theo một tài liệu thanh toán mà TIME đã xem, Sama gửi cho OpenAI một lô mẫu gồm 1,400 hình ảnh. Một số hình ảnh đó được phân loại “C4” (phân loại nội bộ của OpenAI cho lạm dụng tình dục). Theo tài liệu thanh toán, lô này cũng bao gồm hình ảnh “C3” (gồm thú tính, hiếp dâm, nô lệ tình dục) và hình ảnh “V3” mô tả chi tiết đồ họa về cái chết, bạo lực hoặc thương tích nặng. Tài liệu cho thấy OpenAI đã trả cho Sama tổng cộng $787,5 để sàng lọc chúng.

Nhưng vài tuần sau, Sama bất ngờ hủy bỏ dự án mới và toàn bộ hợp đồng với OpenAI, sớm hơn tám tháng so với thỏa thuận trong hợp đồng. Công ty gia công phần mềm nêu lý do: “Dự án mới thu thập hình ảnh cho OpenAI không gồm bất kỳ hướng dẫn nào về các dữ liệu thu thập vi phạm pháp luật Mỹ. Chỉ sau khi công việc bắt đầu, OpenAI mới gửi hướng dẫn bổ sung một số danh mục bất hợp pháp”.

Quyết định của Sama chấm dứt công việc với OpenAI đồng nghĩa với việc nhân viên của Sama không còn bị “tập kích tinh thần” bằng những văn bản và hình ảnh tởm lợm. Tháng Ba 2022, Sama giao lô dữ liệu được đánh dấu cuối cùng cho OpenAI. Do các hợp đồng bị hủy sớm, cả OpenAI và Sama đều cho biết khoản tiền $200,000 mà họ đã đồng ý trước đó sẽ không được thanh toán đầy đủ.

Tất nhiên nhu cầu “đánh dấu” dữ liệu xấu cho các hệ thống AI vẫn còn cần thiết, ít nhất ở thời điểm hiện tại. “ChatGPT và các công cụ chatbot AI khác không phải là ma thuật mà vẫn phải dựa vào lao động của con người trong việc sàng lọc dữ liệu” – Andrew Strait, một nhà đạo đức học về AI viết trên Twitter.